AI存在偏见和歧视,算法让用户喜好趋同?科学家给出了证据

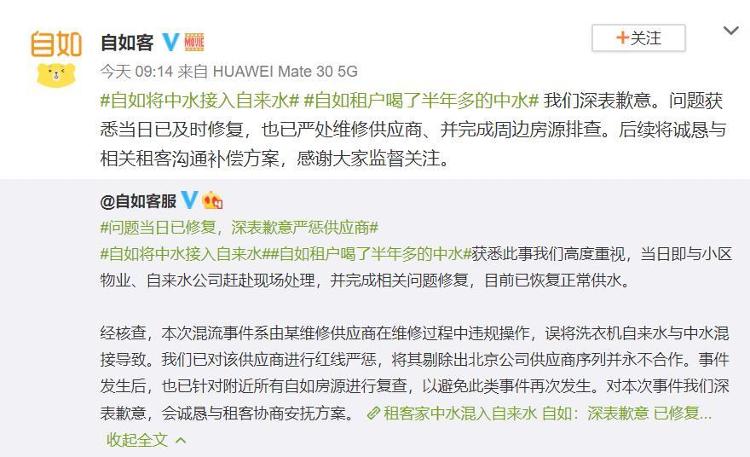

或许你已经注意到了,当你在电影评分网站给刚看完的电影评完分后,网站后续给你推荐的影片风格会与你看完的电影类似。举个更常见的例子,当你在购物网站搜索过某样物品后,第二天推荐页面上显示的都是类似款。

人工智能可以帮助商家获得客户喜好,但同时也在逐渐根据用户的反馈,形成喜好偏见,让用户的需求同化。不仅如此,在人脸识别领域,算法自带的歧视和偏见导致的问题,已经引发了诸多争议。

近日,来自多所大学学者的研究结果为上述的偏见和歧视提供了证据。他们的研究论文目前已在预印本网站Arxiv上发布。

算法推荐系统会放大偏见,并让用户喜好趋同

推荐系统的本质是一种基于产品内容或用户行为的信息过滤。如今,我们用的很多应用程序和网站都嵌有算法推荐系统。假如你在某视频网站给一部电影打了高分,那么系统就会为你推荐更多同类型的电影。如果你给系统推荐的电影也打了分,系统就会将你的反馈行为添加到系统中,这就是一种反馈循环。

但是推荐算法会受到流行性偏见(popularity bias)的影响。流行性偏见是指,一些流行的项目会被经常推荐,而其他项目会被忽略。在上面的例子中,一些电影被更多的人喜爱,获得了更高的评分,就属于流行的项目,或者可以叫做热门项目,这些项目会被更多推荐给用户,这就是流行性偏见。

流行性偏见的产生一部分源于训练数据本身存在不同的流行度,另一部分原因来自推荐算法。随着时间的推移,这种流行性偏见将会被加强。因为如果用户在反馈循环中不断为热门电影打高分,这些电影就变得更热门,被推荐的几率也就更大。

为了研究反馈循环对推荐系统放大偏见和其他方面的影响,来自埃因霍温科技大学、德保罗大学和科罗拉多大学博尔德分校的研究人员在一个电影数据集上使用三种推荐算法进行了仿真,模拟推荐系统的交互过程。

作为研究数据的MovieLens 1M数据集包含了6040个用户对3706部电影给出的1000209个评分,分数范围在1-5之间。研究人员使用的三种推荐算法分别是:基于用户的协同过滤(UserKNN)、贝叶斯个性化排序(BPR)和一种向所有人推荐最流行产品的算法MostPopular。

通过使用这些数据和算法进行迭代——系统不断为用户生成推荐列表,用户又不断对推荐列表中的项目进行打分,研究人员发现,随着时间的推移,三种算法下的数据平均流行度都有所上升,但总体多样性呈现下降,这也就证明了推荐系统在反馈循环后的偏见被放大。

流行性偏见的放大还改变了系统对用户兴趣的判断。在所有的推荐算法中,用户的偏好与其初始偏好之间的偏差随着时间的推移而增加。也就是说,这将导致推荐系统为用户做出的推荐越来越偏离用户的真实喜好,系统推荐给你的电影将不再符合你的口味。

除此之外,由于推荐系统的偏见被放大,用户几乎只能接触到流行度高的项目,只能看到那些被更多人打了高分的热门电影。于是,在推荐系统中他们的偏好都会向一个共同的范围集中,这就表现为用户偏好的同质化。而反馈循环造成的偏见对少数群体用户的影响更大。

“解决算法偏见的方法变得至关重要。因为如果处理不当,随着时间的推移,推荐系统中一个很小的偏差也可能会被极度放大。”研究人员在论文结尾处写道。

人脸识别用于训练的数据存在巨大偏差

针对人脸识别算法带来的偏见越来越受到关注。例如,能将模糊照片清晰化的PULSE算法将美国前总统奥巴马的模糊照片“还原”出了一张白人面孔,在全美BLM运动(Black Lives Matter,黑人的命也是命)如火如荼的背景下,就引发了巨大的争议。

人脸识别领域里出现算法偏差和歧视,一个重要原因是用于训练的数据集存在很大的偏差性。来自剑桥大学和中东科技大学的研究人员就从两个用于识别人脸表情的数据集中找到了证据。

这两个数据集分别为:RAF-DB和CelebA。其中,RAF-DB包含来自互联网的数以万计的图片,这些图片包括面部表情和属性注释,而CelebA拥有202599张图像,包含10177人的4 0种属性注释。

为了确定两个数据集存在偏差的程度,研究人员对随机子集进行了采样,并裁剪了图像,以使面部在方向上保持一致。然后,他们使用分类器来衡量准确性和公平性。

理论上来说,为了让算法保持准确和公平,这个分类器应在整个过程中提供不同的人口群体的相似结果。但实际情况并非如此。

在RAF-DB数据库中,绝大多数的图片来自年龄在20-39岁之间的白人。从具体的数据来看,这些图片有77.4%来自白人,15.5%来自亚裔,而只有7.1%来自非洲裔美国人;在性别方面,女性为56.3%,男性为43.7%;在年龄上,超过一半的图片来自20-39岁的年轻人,3岁以下和70岁以上的人甚至少于10%。

为进一步研究数据库存在偏见的程度,研究人员分别使用了三种算法对数据库的准确性和公平性进行评估。结果发现,在准确性方面,RAF-DB数据库对少数族裔的识别准确性低于白人;在公平性方面,性别属性相对更公平,为97.3%,种族和年龄的公平性相对较低,为88.1%和77.7%。

而在CelebA数据库的图片来源中,女性比例为61.4%,而男性只有38.6%。在年龄上,年轻人占75.7%,明显超过了占比24.3%的老年人。

在准确性方面,CelebA数据库对年轻女性的准确率为93.7%,但对老年男性的准确性较低,为90.7%。而该数据库在性别和年龄方面的公平性表现都较好,分别为98.2%和98.1%。

许多公司曾用人脸识别软件给面试者的情绪打分,如果整个系统都是有偏见的,对于面试者来说就意味着不公平。面部表情数据集中偏见的存也凸显了监管的必要性。如何用法律防止技术滥用,成为未来这一领域里值得思考的问题之一。

澎湃新闻记者 王心馨 实习生 何青怡 【编辑:刘羡】

相关推荐

猜您喜欢

- 中国将施行修改后的预算法实施条例

- 财政部长解读预算法实施条例,有7大变化

- 中华人民共和国预算法实施条例

- 贺仁龙:工业互联网最终会演变成算法平台

- 国防部:美防长言论充斥着傲慢与偏见、攻击与抹黑

- 影创科技胡金鑫:人工智能时代需要更多的图像类算法人才

- 计算机专家聚焦人工智能隐私保护和算法公平问题

- 单靠算法无法乘风破浪,AI赋能传统产业的核心逻辑是什么?|另一种可能

- 天准科技穿越周期的成长:精研算法硬件,坚持高端检测

- 房贷一族注意了,房贷算法要变!

- Cortana小娜失败背后,微软的傲慢与偏见

- 科大讯飞刘庆峰:从目前可见的算法中,没有见到能改变人类的

- Hannah Rozenberg开发无性别偏见的建筑设计在线工具

- 隐私权小组希望FTC探索Google跟踪算法

- 算法帮助AI在传奇的Atari游戏中获胜